L’intelligenza artificiale sta vivendo una fase di entusiasmo senza precedenti, accompagnata da aspettative elevate e da un’adozione sempre più ampia. Ma insieme ai benefici, emergono anche rischi molto concreti. Con l’esplosione dei sistemi di AI generativa, abbiamo già assistito a episodi che mostrano un potenziale oscuro. Si pensi al caso del giovane americano suicida dopo l’interazione con un chatbot, o agli effetti pervasivi di Clothoff, il sistema per la generazione di immagini pornografiche false di persone reali. Ma i pericoli non si limitano al digitale. Incidenti d’auto a guida autonoma, malfunzionamenti di robot impiegati in contesti industriali e analoghi in eventi pubblici. Gli errori di progettazione e la mancanza di controllo umano possono tradursi in danni fisici e in violazioni dei diritti fondamentali.

Come in ogni fase di grande innovazione tecnologica, il punto non è “se” usare l’AI, ma “come” adottarla in modo responsabile. Prima ancora di scrivere una riga di codice o acquistare una soluzione AI, bisognerebbe domandarsi:

“Quale impatto avrà questa tecnologia sulla società, sulle persone, sui loro diritti?”

Dal 2 agosto 2026, l’introduzione dell’obbligo di “FRIA” per l’utilizzo di sistemi ad alto rischio imporrà di porsi questa domanda in un modo ben strutturato. Vediamo allora in cosa consiste l’adempimento, e il suo valore etico e giuridico.

Indice

AI Act e tutela dei diritti fondamentali

Con l’entrata in vigore del Regolamento (UE) 2024/1689 sull’intelligenza artificiale (AI Act), l’Unione Europea ha riconfermato il paradigma di governance del rischio tecnologico, affiancando al modello della protezione dei dati quello della protezione dei diritti fondamentali.

L’AI Act introduce infatti un obbligo esplicito per chi utilizza l’AI in determinati contesti: la Valutazione d’Impatto sui Diritti Fondamentali (Fundamental Rights Impact Assessment – FRIA). L’articolo 27 stabilisce che, prima di mettere in uso sistemi AI classificabili come “ad alto rischio”, i soggetti che li adottano devono condurre una valutazione strutturata dell’impatto che tali sistemi possono produrre sui diritti e le libertà delle persone. L’obiettivo è dimostrare che l’uso dell’AI non altera gli equilibri fondamentali tra individui, imprese e poteri pubblici, e che il potenziale impatto sulla dignità, la libertà, l’uguaglianza, la cittadinanza e la giustizia sociale sia valutato, documentato e gestito in modo consapevole.

I rischi per i diritti fondamentali non dipendono soltanto dal modo in cui un sistema AI è progettato (responsabilità del provider), ma anche dal modo in cui viene concretamente utilizzato (responsabilità del deployer).

[vedi anche Provider e Deployer nell’AI Act: chi sono e cosa fanno?]

Chi impiega un sistema AI è coinvolto nella tutela dei diritti poiché conosce meglio il contesto d’uso, le persone coinvolte e quelle potenzialmente esposti agli effetti delle decisioni automatizzate. Il deployer, inoltre, è tenuto a informare gli individui interessati sull’uso del sistema, sul tipo di decisioni che esso contribuisce a prendere, e sul diritto a ricevere una spiegazione, in coerenza con il principio di trasparenza previsto dal regolamento.

FRIA e DPIA: due strumenti complementari

Per chi è abituato al lessico del GDPR, la FRIA ricorda senza dubbio la DPIA (Data Protection Impact Assessment) (ex art. 35 GDPR). Effettivamente, entrambe le valutazioni condividono l’approccio by-design, contribuiscono al principio di accountability e sono utili a documentare in modo trasparente le scelte compiute nell’adozione e nella governance delle nuove tecnologie. In entrambi i casi, si tratta di strumenti che aiutano a prevenire, identificare e gestire nel tempo i rischi intrinseci derivanti dall’utilizzo di nuove tecnologie.

Il perimetro della DPIA, tuttavia, si concentra sulla conformità ai principi di liceità, minimizzazione, trasparenza e sicurezza, e sui rischi derivanti dal trattamento di dati personali. Peraltro, sebbene l’art. 35 GDPR parli di “impatti sui diritti e sulle libertà fondamentali”, nella prassi applicativa l’attenzione si concentra prevalentemente sulle conseguenze in caso di violazione di riservatezza, integrità o disponibilità dei dati. Anche se tante volte, in gioco, non c’è solo il diritto alla protezione dei dati personali. Un esempio tra tanti, l’algoritmo per la gestione dei rider sanzionato a inizio 2021: problematiche nel trattamento dati possono invadere altri diritti, come in quel caso, quello del lavoratore a non essere discriminato.

La FRIA, d’altra parte, abbraccia fin dalla sua nomenclatura una prospettiva più ampia e indirizzata chiaramente verso i diritti fondamentali. Si parla perciò dei diritti descritti dalla Carta dei diritti dell’UE, 50 articoli suddivisi nei temi di Dignità, Libertà, Uguaglianza, Solidarietà, Cittadinanza, Giustizia. È a questo corpus che la FRIA chiede di guardare per valutare l’impatto dell’innovazione. Un sistema AI rischia di incorrere, per esempio, in bias algoritmici e portare alla discriminazione di determinate classi o categorie sociali. Può provocare limitazioni di accesso a prestazioni pubbliche od opportunità lavorative. Può generare effetti di sorveglianza sproporzionata, incidere sulla libertà di informazione e sul pluralismo, ecc.

Ragionare in termini di diritti fondamentali significherà superare un approccio centrato esclusivamente su violazioni, incidenti o malfunzionamenti. Si pensi ai progetti di generazione di avatar e identità digitali capaci di sopravvivere oltre la morte fisica dell’individuo: anche nel loro funzionamento più sicuro, sistemi AI a supporto di queste soluzioni non possono che sollevare dilemmi etici profondi legati all’identità digitale e all’“immortalità digitale”. Quanto possono incidere tecnologie di questo tipo sulla dignità della persona e sulle relazioni interpersonali. Perfino il funzionamento ottimale di un sistema può alterare equilibri sociali.

L’ampia portata dell’AI apre ufficialmente la strada alla necessità di sviluppare un modello quanto più completo di gestione del rischio tecnologico. E anche dal punto di vista operativo, la prossimità concettuale tra DPIA e FRIA, pur nella diversità dei rispettivi perimetri, è coerente con quanto previsto dall’art. 27.4 dell’AI Act: la FRIA può integrare e completare la DPIA già condotta ai sensi del GDPR, ampliandone l’analisi agli ulteriori diritti fondamentali coinvolti dall’uso dell’AI.

Quando è obbligatoria la FRIA?

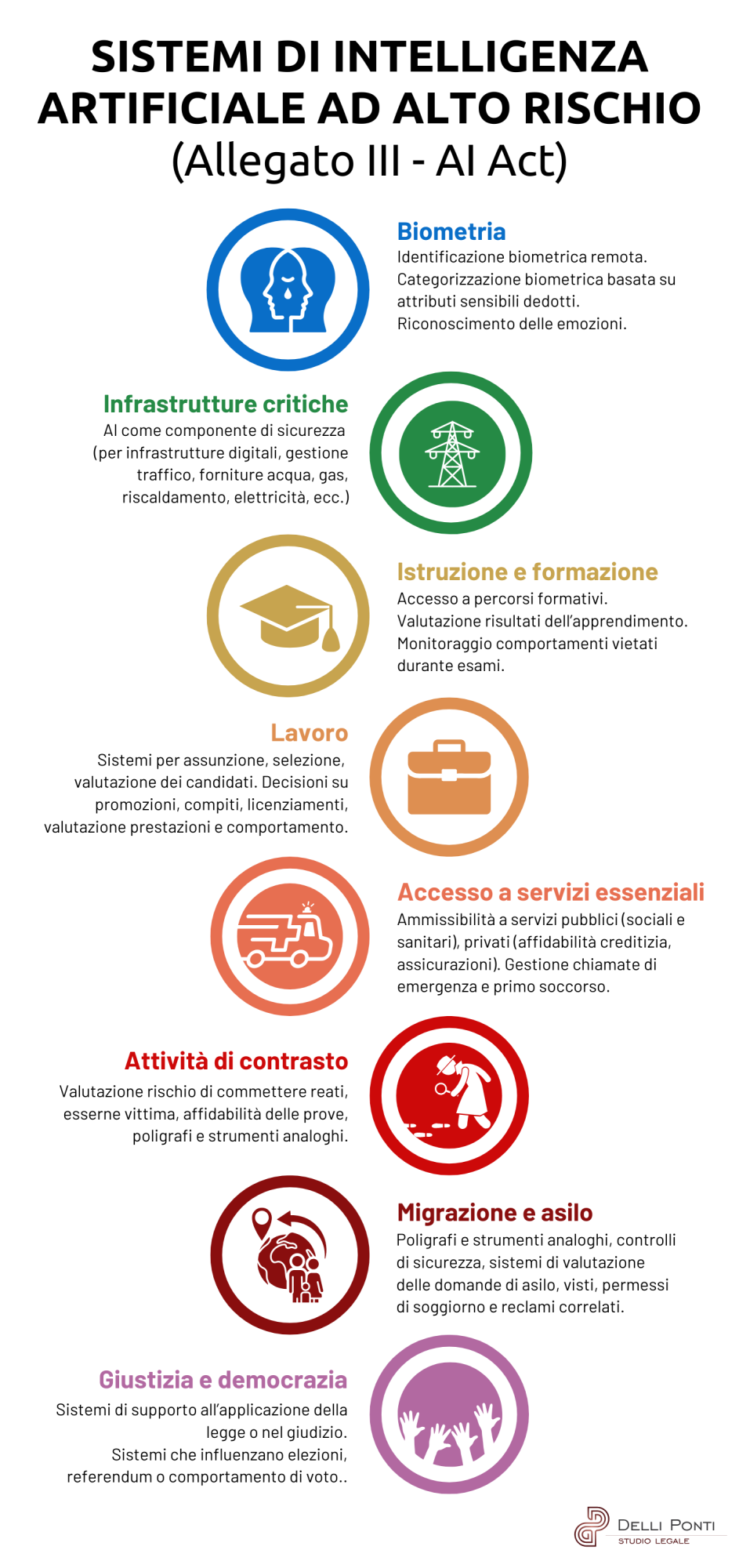

La FRIA è richiesta ai deployer di sistemi AI classificati come ad alto rischio ai sensi dell’art. 6 e dell’Allegato III dell’AI Act.

In tutti i casi descritti dalla norma, la FRIA dovrà essere condotta prima della messa in uso del sistema, aggiornata in caso di modifiche sostanziali. Infine, importante differenza rispetto alla DPIA, la valutazione dovrà essere notificata all’autorità dello Stato.

Qual è l’autorità competente in Italia?

Il legislatore nazionale, attraverso la Legge nazionale sull’AI, ha attribuito competenze distinte a AgID e ACN, delineando un sistema in cui:

- AgID (Agenzia per l’Italia Digitale) è responsabile della promozione, sviluppo e regolazione amministrativa dell’AI, delle procedure di notifica, valutazione, accreditamento e monitoraggio dei soggetti incaricati della verifica di conformità.

- ACN (Agenzia per la Cybersicurezza Nazionale) esercita funzioni di vigilanza, ispezione e sanzione sui sistemi AI, con particolare attenzione ai profili di cybersicurezza.

Sembrerebbe quindi AgID l’autorità competente. Tantopiù che a febbraio 2025 ha divulgato (per la consultazione pubblica), una Bozza di linee guida per l’adozione di Intelligenza Artificiale nella Pubblica Amministrazione, che ha tra i suoi allegati uno strumento di supporto per la valutazione d’impatto.

A prescindere dall’autorità competente e dalle modalità di trasmissione, la FRIA dovrà includere almeno gli elementi elencati dall’art. 27 dell’AI Act.

Contenuti minimi della FRIA

- descrizione dei processi in cui il sistema AI sarà utilizzato,

- durata, periodicità e condizioni d’uso del sistema,

- categorie di persone e gruppi potenzialmente interessati dall’uso dell’AI,

- rischi specifici che l’uso del sistema può comportare per tali persone,

- misure di supervisione umana previste,

- misure di gestione e mitigazione da adottare qualora i rischi si concretizzino.

Come redigere una FRIA?

Il documento FRIA model: Guide and Use Cases dell’Autorità Catalana per la Protezione dei dati (APDCAT) è ad oggi uno dei riferimenti più completi per tradurre l’articolo 27 dell’AI Act in metodologia operativa. La logica del modello si basa su tre fasi principali.

Fase 1 – Pianificazione

La metodologia sviluppata dall’APDCAT prevede, come primo passaggio, una fase di pianificazione e definizione del perimetro della valutazione. In questo momento iniziale è necessario chiarire la finalità e il contesto d’uso del sistema AI, identificare i soggetti coinvolti lungo il suo ciclo di vita (provider, deployer, user e persone potenzialmente impattate) e descrivere durata, frequenza e modalità operative con cui il sistema sarà impiegato.

Occorre inoltre individuare i diritti fondamentali e i gruppi sociali che potrebbero essere interessati dall’utilizzo, come lavoratori, studenti, pazienti, cittadini, ecc.

L’obiettivo di questa fase è costruire una rappresentazione chiara del sistema e dell’ecosistema in cui dovrà operare, distinguendo fin da subito i rischi legati al design e alla tecnologia, da quelli connessi al contesto di implementazione, all’integrazione con altre tecnologie o alle dinamiche organizzative e sociali in cui il sistema sarà introdotto.

Fase 2 – Analisi dei rischi e raccolta dati

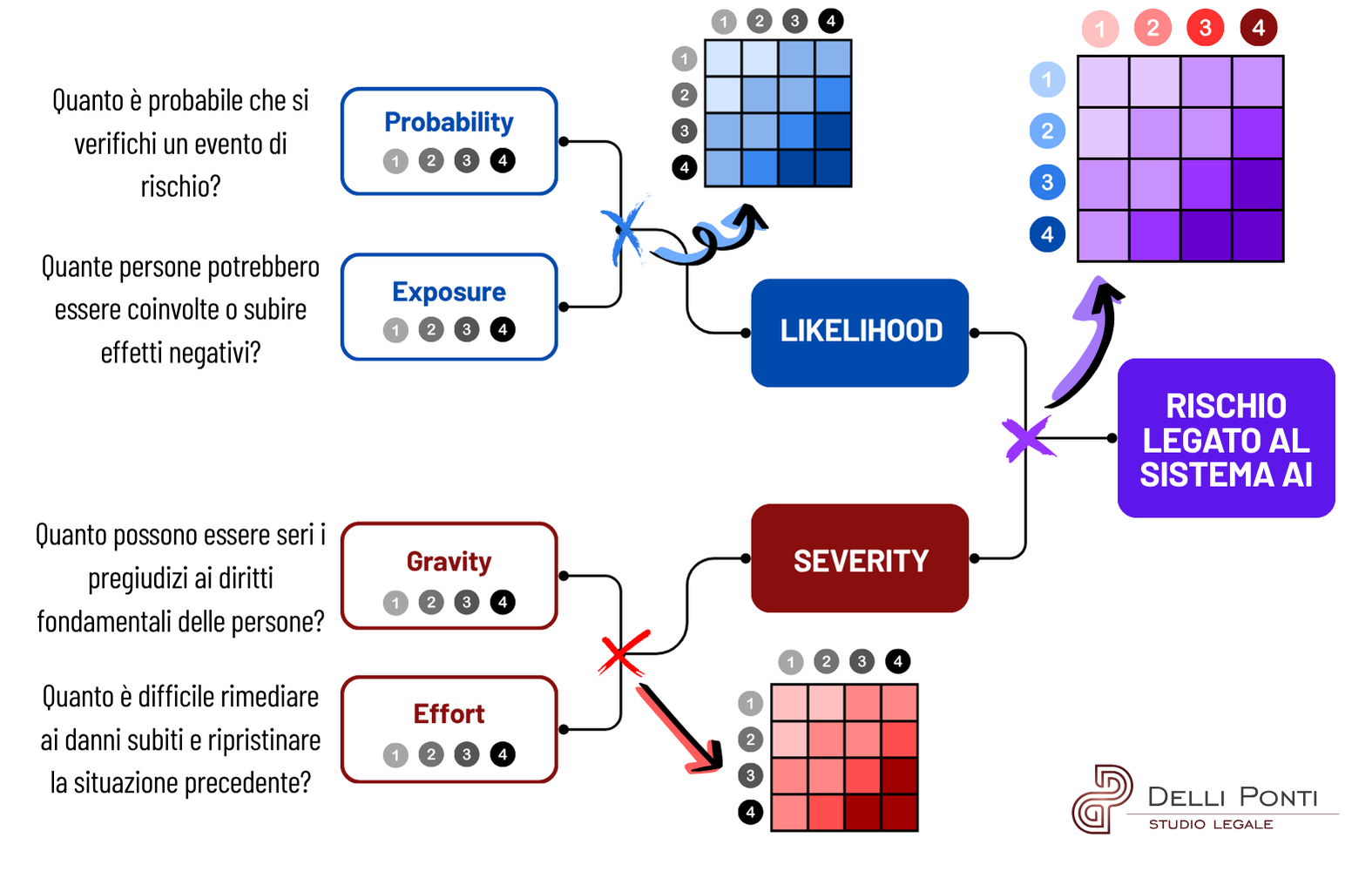

La seconda fase rappresenta il cuore della valutazione: il modello APDCAT propone un approccio quantitativo per l’identificazione e la misurazione dell’impatto sui diritti. Anche se la traduzione in italiano dei costrutti non renderebbe bene l’idea, l’invito è quello di costruire un indice di impatto che tenga conto:

- della probabilità (“likelihood“) dell’evento dannoso, distinta in

- probability ed

- exposure; e

- della gravità (“severity“) del pregiudizio, distinta invece tra

- gravity ed

- effort.

Questo modello permette di descrivere il rischio complessivo di un sistema AI attraverso una “matrice di matrici”. Applicata più volte a ciascuno dei diversi diritti fondamentali potenzialmente impattati, il metodo metterà in evidenza quali sono maggiormente esposti. Consentirà di valutarli e di stabilire le priorità per le misure correttive necessarie. Aspetto fondamentale: ciascun diritto dovrà essere valutato e tutelato singolarmente. Non può esistere alcun “bilanciamento” tra diritti fondamentali.

Fase 3 – Gestione e mitigazione dei rischi

Fase 3 – Gestione e mitigazione dei rischi

L’ultima fase riguarda la definizione, l’attuazione e il monitoraggio delle misure di mitigazione. Si tratta di un insieme coordinato di controlli tecnici, organizzativi e procedurali che possono includere, ad esempio, l’introduzione di forme effettive di supervisione umana nelle decisioni automatizzate, la revisione e il ribilanciamento dei dataset, l’aggiornamento dei criteri di addestramento, la predisposizione di meccanismi di reclamo e procedure per l’intervento umano, l’adozione di misure di auditing, programmi di formazione del personale e iniziative informative rivolte agli utenti.

A questo proposito risultano particolarmente utili le Linee guida dell’EDPS sulla gestione del rischio dei sistemi AI, che rafforzano l’approccio della FRIA e collocano la mitigazione all’interno dell’intero ciclo di vita del sistema. Ogni misura di mitigazione deve essere calibrata rispetto allo stadio di vita del sistema e aggiornata nel tempo. Particolare rilievo assumono i principi di:

- interpretabilità e spiegabilità. Spesso erroneamente ritenute contrarie al concetto di AI, in realtà sono da considerare elementi irrinunciabili. L’obiettivo è comprendere come il sistema AI prenda le decisioni e quali fattori influenzino i risultati, tramite idonea documentazione tecnica e il coinvolgimento di figure competenti.

- accuratezza. Da intendersi sia come qualità del dato di input, sia come robustezza e affidabilità dei risultati generati da un modello. Le misure di mitigazione devono quindi includere la validazione periodica del sistema, l’aggiornamento dei dati, la verifica dei tassi di errore rispetto a gruppi diversi di popolazione, la gestione delle inferenze errate e delle “allucinazioni” tipiche dell’IA generativa.

- contrasto ai bias, che richiama tecniche di controllo e auditing dei dati di training, prove che coinvolgono popolazioni rappresentative, controlli sulla scelta dei fornitori (nel caso di soluzioni acquistate) e formazione del personale.

La prospettiva dell’EDPS conferma quindi che, come accade per la DPIA, anche la FRIA (e più in generale la gestione del rischio) dovrà configurarsi come un processo ciclico, in grado di accompagnare l’evoluzione tecnica del sistema o i cambiamenti del contesto operativo mediante riesami e aggiornamenti periodici (o, meglio ancora, tramite un processo permanente di monitoraggio).

Verso un approccio integrato al rischio AI

Dal punto di vista operativo, una delle principali sfide per le imprese sarà riuscire a integrare la FRIA nei propri processi di compliance. Molte organizzazioni dispongono già di procedure di DPIA consolidate e, come spesso accade, la soluzione più efficiente sarà quella di adattarle. Unire le matrici di rischio privacy, cybersecurity, qualità, a quelle relative ai diritti fondamentali. Soddisfare esigenze normative trasversali tramite un unico presidio.

Un ostacolo rilevante potrebbe invece riguardare i risvolti esterni del processo di valutazione. La FRIA richiederà praticamente sempre di disporre di competenze interdisciplinari giuridiche, tecniche, organizzative. In alcuni casi, sarà poi opportuno coinvolgere professionalità specifiche, rappresentanti di categoria o altri stakeholder. Mentre la gestione dei rapporti con le Autorità nelle fasi di notifica aggiungerà un ulteriore livello di responsabilità e trasparenza.

Nonostante queste complessità, alcuni principi operativi possono aiutare a vederla dalla giusta prospettiva. Ogni valutazione dovrà essere proporzionata al tipo di sistema e al contesto, sistemi “semplici” non richiederanno valutazioni eccessive. L’attività potrà poi essere facilitata da template e strumenti automatizzati che le istituzioni europee metteranno a disposizione. E l’adempimento potrà valorizzare figure eventualmente già presenti, come DPO, altri ruoli e funzioni responsabili della compliance, e tavoli interdisciplinari. La FRIA deve certamente diventare l’occasione per ripensare il rapporto tra tecnologia e diritti, ma può anche essere l’opportunità di migliorare i processi di sviluppo e innovazione. L’importante, sarà ricordare che la conformità non è nemica della competitività, anzi, può diventarne uno dei motori più sostenibili.